AI 新手的第一次把玩

目录

网上关于ai新闻的报道一大推,都是开源的大模型,比如chatgpt、gpt-3.5、gpt-4。国内出名的比如 文心一言、讯飞星火、豆包等等。 处于国情原因,国外的大部分网站,在国内是无法正常使用的。所以我开始尝试国内的AI模型,首先使用的是Baidu的文心一言。

谈谈使用感受:

- 比如:我在写一些文档的时候,需要将英文翻译为中文,但是通过有道和文心一言的对比,文心一言翻译的结果更准确一些,语义更贴合原文的语义。尤其是对比一些专业的术语,文心一言翻译的结果更好。

- 还有在找一些资料的时候,直接询问文心一言,可以快速找到想要说明,同时它还会给出一些相关的资料,非常适合进行相关的学习补充。但它目前主要是对百度自己收录的网站和内容进行筛选,所以对于一些非百度收录的网站,它就无能为力了,不过这也是可以理解的,毕竟它只是一个AI模型,它没有能力去判断一个网站是否是百度收录的,同时,作为百度的产品,使用百度收录的数据,是很正常也很符合国内用户情况的。在现阶段,对于各大社区提供的资料来说,它还是可以满足大部分用户的需求的。

- 再有,平时想组建一个小的产品时,可以将自己的思路告诉AI,它会给出一些相关的建议和修改,并继续做补充,同时,你还可以继续向它咨询,它会接着上一个问题继续回答你,这很适合一些产品经理和程序员,可以节省很多的时间,也会让自己了解到一些自己以前从没有接触过的知识内容。

以上只是我目前这段使用的一些使用感受,相较于传统手机厂商开发的语音助手,大模型AI人工智能确实要优秀的多,能过获得流利的对答体验。当然,它也有失手的时候,毕竟,它也知识一个模型而已,所以需要我们在使用时,要将自己的需求尽可能的描述的清晰明了,这样它的回答也会更准确一些。

通过这些天的使用,它确实给我的开发工作提供了不小的助力,现在使用它已经变成一种习惯了,尤其是在出现一些BUG时,有一些专业术语需要解释时,有一些其他的开发架构的想法时,都会让它来印证我的想法,解决我遇到的问题。相较于在搜索引擎里漫无目的查找,通过它来做索引,终于可以从烟波浩渺的各种信息中找到自己想要的答案了。

本地搭建

网上的模型千千万,但毕竟都是需要注册使用的,网络瘫痪,就没有了。而且数据都是共享的,没有私密性可言。这时候,就需要自己在本地搭建一个属于自己的模型了。好在,国内国外各大AI公司都出了很多开源的大模型,我们自己就可以免费在本地搭建。搭建在本地,我们可以使用我们本地的数据,同时还能创建一个属于自己的知识库,配置模型只使用本地的数据,这样你就拥有了一个自己的虚拟图书馆。比如,你要学习一门新课程,你可以将这门知识的相关书籍资料全部汇入知识库中,让模型自己去解析生成,之后你就可以在对话框中,以问答的方式,快速开始了解这门课程了。这要比我们自己一行一行的读那些索然无味的文字要高效的多。这也是我想在本地搭建的原因之一。试想,谁不想拥有一个属于自己的AI机器人呢。

但本地搭建的一个弊端就是,这个东西十分消耗系统资源。所以,搭建之前,一定要做好充足的准备,比如:内存、CPU、GPU、硬盘、网络等等。如果你的电脑配置不够,那还是不要折腾了,直接使用网上的模型吧。

但也不是说,电脑的配置不够,就不能搭建玩玩了。通过我这些天的折腾,我终于在本地搭建了一个小型的模型,它能够给我提供一些基本的问答,生成一些简单的文章,解决一些简单的问题。应对我们日常使用还是够用的。

本地搭建步骤

这里我先介绍一下,我的电脑配置情况,方便大家做对照:

| 硬件 | 参数 |

|---|---|

| 系统 | macOS Monterey 12.7.5 Mac mini (Late 2014) |

| CPU | 2.6 GHz 双核四线程Intel Core i5 |

| GPU | 集成 Intel Iris 1536 MB |

| RAM | 8 GB 1600 MHz DDR3 |

下载 ollama

ollama 是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。以下是对Ollama的详细解释:

- 简化部署:Ollama的主要目标是简化在Docker容器中部署大型语言模型的过程,使得非专业用户也能方便地管理和运行这些复杂的模型。

- 轻量级与可扩展:作为轻量级框架,Ollama在运行时占用较少的资源,同时具备良好的可扩展性,允许用户根据需要调整配置以适应不同规模的项目和硬件条件。

- API支持:Ollama提供了一个简洁的API,使开发者能够轻松创建、运行和管理大型语言模型实例,降低了与模型交互的技术门槛。

- 预构建模型库:Ollama包含一系列预先训练好的大型语言模型,如Llama 3.1、Phi 3、Mistral、Gemma 2等,用户可以直接选用这些模型应用于自己的应用程序,无需从头训练或自行寻找模型源。

- 模型导入与兼容性:Ollama支持从多种平台(如GGUF)和深度学习框架(如PyTorch或Safetensors)导入已有的大型语言模型,并允许用户自定义提示(prompt engineering),以引导模型生成特定类型或风格的文本输出。

- 跨平台支持:Ollama提供了针对macOS、Linux以及Windows(预览版)的安装指南,确保用户能在多种操作系统环境下顺利部署和使用。

- 易用性:通过简单的安装和配置过程,用户可以快速启动和运行Ollama服务,并通过命令行或UI界面与大型语言模型进行交互。

- 功能丰富:除了基本的模型运行功能外,Ollama还支持任务管理、数据分析、自动化流程等高级功能,帮助用户提高工作效率和数据处理能力。

- 社区支持:Ollama拥有一个活跃的社区,用户可以在这里分享经验、获得帮助并获取最新的更新和特性。

- 未来展望:随着Ollama的不断发展,它将支持更多模型架构、提供更多预构建模型、增强性能和扩展功能,以满足用户对大型语言模型不断增长的需求。

综上所述,Ollama是一个功能强大、易于使用且可扩展的开源框架,它极大地简化了在本地机器上部署和运行大型语言模型的过程,为开发者和研究人员提供了极大的便利。

综上所述,先在本地安装 ollama客户端,它目前支持macOS(macOS 11 Big Sur or later)、Linux以及Windows(需要win10以上)。

安装完成后,访问 https://ollama.com/library,挑选适合自己的模型。

这里常用的有:llama3.1、gemma2、qwen、qwen2、phi3。这里我选择了 qwen2:0.5b,Qwen2是阿里巴巴集团的一系列新的大型语言模型,而且该模型占用内存特别小。

执行以下命令,将该模型安装到本地

ollama pull qwen2:0.5b

之后,通过执行以下命令,就可以在命令行中,和该模型进行对话了。

ollama run qwen2:0.5b

但是该方式,只能在命令行中和该模型进行交互,为了操作该模型,我们需要一款像 文心一言一样的交互式UI界面。

安装UI界面操作模型

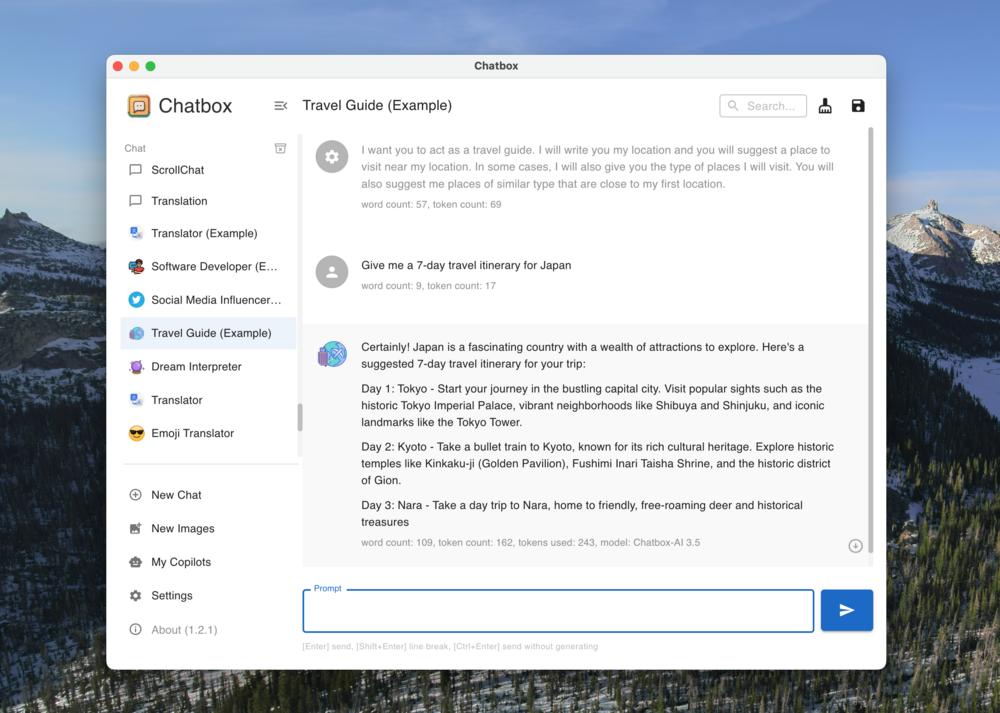

这里我选择了 ChatBox,Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。

这里我选择了 ChatBox,Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。

下载安装完成后,在设置界面,下拉 模型提供方,选择 Ollama,

api域名输入 http://127.0.0.1:11434,模型选择 qwen2:0.5b,点击 保存,就可以在UI界面中,和该模型进行交互了。

相较于其他的离线版UI,该App简单但功能强大,可以满足我们日常使用。同时资源消耗不算高,我也试过了其他的web托管,但最轻型的也是基于nextjs使用的,编译托管后占用内存特别高,而且只有基本的聊天功能。但这款APP,除了支持对话,还支持、文件上传、图片上传、图片生成,但这三个功能需要结合其他支持该模式的模型才可使用,qwen2:0.5b 这款模型是不支持的,但 qwen2 的其它版本,或者其它的模型,应当是具有该功能的,大家可以试试。

它的另一个特色是,它提供了几个自带的实例,你也可以自己定义对话时的模型,给它设定特殊的角色和定位,这会让你的问答更具特色。但遗憾的是,它不支持知识库功能,如果你想要在本地搭建一款知识库的话,那你需要考虑 FastGPT、 lobeChat等等。其它的UI界面也还有 Open WebUI、ollama ui等等。大家可以根据自己的喜好和电脑配置,选择一款自己喜欢的。

其它几款常见模型在我当前电脑的资源占比情况,如下图:

| 模型名 | 体积 | RAM 占用 | Dight |

|---|---|---|---|

qwen2:0.5b | 352 MB | ≈ 500 MB | 6f48b936a09f |

qwen:0.5b | 394 MB | ≈ 1.17 GB | b5dc5e784f2a |

gemma2:2b | 1.6 GB | ≈ 2.23 GB | 8ccf136fdd52 |

phi3:3.8b | 2.2 GB | ≥ 5.3 GB | 4f2222927938 |

大家可以根据自己的电脑配置,选择一款自己喜欢的模型。